VISIÓN EMPRESARIAL

El big data en la cadena de suministro permite crear estrategias innovadoras que ayuden a las empresas a impulsar las operativas logísticas. Al analizar todos los datos que se generan en sus bodegas, las compañías pueden detectar oportunidades de mejora y tomar decisiones estratégicas para el negocio.

La proliferación de dispositivos conectados a internet se ha multiplicado en el último lustro. Un estudio de la consultora International Data Corporation apunta que en 2025 habrá más de 41.000 millones de dispositivos inteligentes en todo el mundo: se espera que el conjunto de dispositivos produzca ese mismo año un volumen de datos superior a los 79,4 zettabytes.

El crecimiento exponencial del volumen de datos generados ─conocido con el anglicismo big data─ presenta una oportunidad única para mejorar los procesos y la toma de decisiones en las organizaciones. En palabras de la consultora tecnológica Gartner, “el big data son activos de información de gran volumen, alta velocidad o gran variedad que exigen formas rentables e innovadoras de procesamiento de información que permiten una mejor comprensión, toma de decisiones y automatización de procesos”.

El análisis de big data facilita la extracción de información útil de grandes volúmenes de datos. Para segmentar y transformar los datos, en los últimos tiempos ha surgido un amplio abanico de tecnologías big data ─como Cassandra, Integrate o MongoDB, entre otras─, capaces de recabar y manejar un volumen ingente de información que sería imposible analizar con programas tradicionales.

La tecnología big data se aplica actualmente en todo tipo de compañías y ámbitos, desde, por ejemplo, en los departamentos de Producción para optimizar el rendimiento hasta en Marketing para segmentar el mercado y conseguir óptimos resultados.

¿Por qué el ‘big data’ es clave en los negocios?

Con el análisis de big data las compañías pueden controlar y procesar la amplia cantidad de datos producidos en sus negocios para identificar nuevas oportunidades.

Según el estudio Big data analytics capabilities and knowledge management: impact on firm performance, “el análisis de big data garantiza que los datos puedan ser analizados y categorizados en información útil para las empresas y transformados en procesos de toma de decisiones eficientes, potenciando así el rendimiento”.

Precisamente es en la toma de decisiones de las empresas donde el big data está empezando a marcar la diferencia. Una investigación multidisciplinar de la Anderson School of Management (EE. UU.) y el College of Economics and Management (China) confirma el rol estratégico del big data en los negocios: “Nuestros resultados empíricos muestran que el uso de la analítica de big data tiene un impacto positivo en la calidad de la toma de decisiones”. Los autores del estudio, publicado en la revista académica Technological Forecasting and Social Change, observan el potencial de la analítica de big data para mejorar la competitividad empresarial. “Las empresas no solo deben fomentar el big data en sus actividades comerciales, sino también incrementar su capacidad de análisis de esos datos, lo que redundará en la calidad de su toma de decisiones y en la consecución de ventajas competitivas”.

‘Big data’ en la cadena de suministro

El big data abre un gran horizonte de oportunidades para los líderes de la cadena de suministro. Un informe de Ernest & Young señala que un 61% de los ejecutivos consultados planea adoptar la analítica de big data en los próximos tres años, mientras que un 33% ya está realizando pruebas piloto o ha implementado herramientas de análisis de datos masivos en algunas áreas de su cadena de suministro.

La analítica de datos puede aportar beneficios durante la producción, el almacenaje, el transporte y la distribución de mercaderías. En la publicación académica Big data analytics in supply chain management, investigadores de la Universidad de Western Illinois (EE. UU.) afirman: “La analítica de big data en la gestión de la cadena de suministro ofrece muchas ventajas como, por ejemplo, la capacidad de predecir mejor la oferta y la demanda, analizar el cambio de preferencias de los clientes o reforzar la visibilidad de la cadena de suministro, pese a que también plantea nuevos retos a las organizaciones”.

Con las herramientas de big data se implementan métodos de análisis que promuevan la toma de decisiones informada en la cadena de suministro. “El análisis de big data ha surgido como un medio para hacer predicciones más precisas que reflejen mejor las necesidades de los clientes, faciliten la evaluación del rendimiento de la cadena de suministro, acrecienten su eficiencia, reduzcan el tiempo de reacción y respalden la evaluación de riesgos”, constatan investigadores del Concordia Institute for Information Systems Engineering (Canadá).

Supply Chain Analytics: ‘big data’ aplicado al almacén

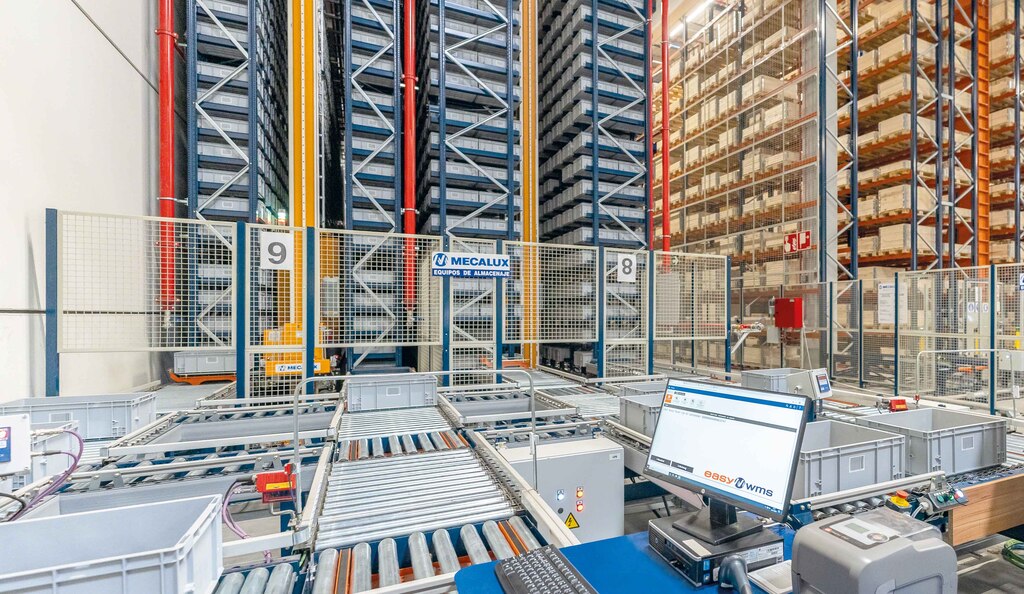

La digitalización de la logística impulsa la utilización de dispositivos conectados a la red que generan un sinfín de datos. Para facilitar su análisis e interpretación, Mecalux ha desarrollado Supply Chain Analytics Software, una funcionalidad avanzada del sistema de gestión de bodegas Easy WMS que segmenta y estructura los datos originados en cualquier instalación.

Al transformar la descomunal cantidad de datos de la bodega en información útil, el responsable logístico puede tomar decisiones con mayor facilidad y exactitud. Supply Chain Analytics Software clasifica los datos para convertirlos en indicadores que muestran una fotografía en tiempo real del desarrollo de las operativas y un análisis histórico del desempeño de la instalación.

El sistema incorpora paneles de mando y gráficas con información básica de la instalación como, por ejemplo, el porcentaje de referencias en stock o de líneas preparadas. El programa también crea indicadores de rendimiento personalizables según los requerimientos de cada responsable logístico.

Supply Chain Analytics Software promueve una logística flexible y productiva que se adapta a las necesidades de las empresas. Por ejemplo, la compañía de productos de embalaje y etiquetado Intermark equipó su bodega con el módulo de analítica avanzada de Mecalux para hacer un seguimiento completo de las operativas logísticas. “El módulo muestra cómo se desarrollan los procesos y nos ayuda a introducir mejoras estratégicas basadas en el desempeño de las operativas diarias. Nuestro mercado es muy dinámico y los requerimientos de los clientes evolucionan con rapidez, lo que nos obliga a transformar nuestro negocio para atender las demandas cambiantes de los clientes. Con este módulo tenemos ahora información basada en datos para proponer cambios que perfeccionen nuestra logística”, explica Juan Pablo Calvo, director general de Intermark.

El análisis de big data también hace que las empresas dispongan de datos fiables y objetivos que permitan modificar y optimizar los procesos. “Easy WMS se ajusta como un guante a las particularidades de nuestro negocio. Con este sistema, podemos conocer la disponibilidad de las referencias y hacer el inventario en tiempo real”, sostiene James Hansen, vicepresidente ejecutivo de Yamazen en Estados Unidos. El distribuidor de máquinas-herramienta utiliza el módulo Supply Chain Analytics Software para consultar y analizar el rendimiento de las operativas en la bodega.

Mecalux ha implementado el módulo Supply Chain Analytics Software en instalaciones logísticas de todo el mundo y para compañías de múltiples sectores. Con esta tecnología, las empresas aplican el big data en sus bodegas con vistas a controlar todo lo que ocurre en la cadena de suministro.

El poder de los datos impulsa la logística

El análisis de big data es de gran utilidad en todas las industrias, si bien en el sector logístico resulta imprescindible. La gran cantidad de datos que se generan en las bodega tiene un enorme potencial para favorecer la toma de decisiones estratégicas.

Las empresas recurren a la tecnología para interpretar la colosal cantidad de datos que se producen a diario en las diferentes áreas del negocio. La analítica big data abre la puerta a nuevas oportunidades de mejora como la optimización de las operativas logísticas, la planificación de futuras inversiones o el lanzamiento de nuevos productos o proyectos.

‘Big data’: una revolución al alza

En 1997, los investigadores de la NASA Michael Cox y David Ellsworth introdujeron el concepto big data en el artículo Application-controlled demand paging for out-of-core visualization. “La visualización de procesos supone un interesante reto para los sistemas informáticos: los conjuntos de datos suelen ser extensos y ponen a prueba la capacidad de la memoria principal, el disco local e incluso el disco remoto. A esto lo llamamos el problema de los grandes datos (big data)”.

A principios del año 2000, la democratización de internet empezó a abrir oportunidades únicas de recopilación y análisis de datos. La expansión de los portales de venta online facilitó que empresas como eBay o Amazon pusieran el foco en el análisis del comportamiento de sus clientes para incrementar el volumen de ventas. Posteriormente, el auge de las redes sociales intensificó la necesidad de contar con herramientas que organizaran la cantidad desmesurada de datos no estructurados que se originaban en la red. No obstante, la llegada del internet de las cosas (IoT) y del machine learning ha disparado el uso de dispositivos conectados, multiplicando las posibilidades del big data.

Aunque las herramientas de análisis big data ya cuentan con un sólido bagaje a sus espaldas, la aparición de nuevas tecnologías como la computación en la nube abren nuevas vías para explotar el potencial del análisis de datos y optimizar el rendimiento de las organizaciones.

Las 5V del ‘big data’

El big data engloba cinco dimensiones, conocidas como las 5V:

- Volumen: la cantidad ingente de información procedente de múltiples fuentes ha de gestionarse mediante nuevas formas avanzadas de administración, explotación y almacenamiento de datos.

- Velocidad: el flujo masivo y constante de datos a un ritmo vertiginoso exige herramientas de recopilación y procesamiento ágiles para evitar la obsolescencia de toda la información que se recoge y analiza.

- Variedad: las herramientas de análisis big data no solo han de procesar fuentes escritas, sino también imágenes, datos informáticos, audios, vídeos, así como todo tipo de contenido en redes sociales y nuevas plataformas.

- Veracidad: el análisis de big data se enfrenta a la necesidad de seleccionar datos veraces para su posterior análisis y descartar la información irrelevante.

- Valor: si los datos recopilados se han seleccionado y analizado de forma adecuada, la información que se obtendrá será de gran valor para la organización.